Intelligent automatisieren.

Schneller wachsen.

NOCODE LTD

Registrationsnummer

HE 449108

[E-Mail geschützt]

Discord

LinkedIn

Facebook

Instagram

Youtube

Reddit

Distilbert Huggingface wurde 2019 als abgespeckte Version des ursprünglichen BERT-Modells entwickelt und eingeführt. Diese Version bietet Entwicklern und Forschern ein effizienteres Tool zur Durchführung von NLP-Aufgaben, ohne dass große Rechenressourcen genutzt werden müssen.

In diesem Artikel wird erläutert, wie dieses Modell zur Lösung von Aufgaben der menschlichen Sprachverarbeitung funktioniert. Sie erfahren auch, wie und in welchen Bereichen es eingesetzt werden kann. Darüber hinaus erfahren Sie nach dem Lesen dieses Handbuchs, wie Sie ein Latenode-Szenario verwenden, das eine direkte Integration mit der Distilbert-Architektur beinhaltet.

Die zentralen Thesen: Distilbert wurde 2019 von Hugging Face entwickelt und ist eine abgespeckte Version des BERT-Modells, die für effiziente NLP-Aufgaben mit reduzierten Rechenressourcen konzipiert ist. Es nutzt Destillation, um Wissen von einem größeren Modell (BERT) auf ein kleineres zu übertragen, wodurch Leistung und Geschwindigkeit verbessert werden, während die Genauigkeit erhalten bleibt. DistilBERT wird in Bereichen wie der Automatisierung des Kundensupports, dem Reputationsmanagement, der Analyse medizinischer Daten, Bildung und Marketing eingesetzt und kann in Latenode integriert werden, um Geschäftsprozesse zu optimieren. Ein Latenode-Szenario demonstriert die Fähigkeit von DistilBERT, die Klassifizierung von Kundenbewertungen zu automatisieren, und demonstriert seine praktischen Anwendungen.

Kuschelgesicht Distilbert ist ein KI-Modell zur Verarbeitung und Klassifizierung natürlicher Sprache. Es handelt sich um eine überarbeitete Version des ursprünglichen BERT-Modells (Bidirectional Encoder Representations from Transformers), das jedoch für bessere Leistung und Geschwindigkeit abgespeckt wurde. Die für den Betrieb dieses Modells verwendete Methode heißt Destillation.

Die Destillation beinhaltet den Wissenstransfer von der Lehrer (das größere Modell BERT) zum Schüler, (das kleinere Modell, Distillbert). Bei diesem Ansatz wird letzterer trainiert, Daten basierend auf den Ergebnissen des ersteren vorherzusagen und zu analysieren. Dabei werden die vom Lehrer vorhergesagten Wahrscheinlichkeiten als weiche Etiketten verwendet, was dem Schüler hilft, subtile Muster zu erkennen und seine Fähigkeit zur Analyse und Klassifizierung von Informationen verbessert.

Der Hauptvorteil dieses KI-Modells ist seine Leistung. Es erfordert weniger Rechenressourcen für Training und Vorhersage und ist daher ideal für ressourcenbeschränkte Umgebungen. Zum Beispiel: Distilbert-Architektur kann auf Geräten mit begrenztem Speicher und begrenzter Verarbeitungsleistung implementiert werden, auf denen die Verwendung von BERT nicht möglich ist.

Gleichzeitig kann diese KI-Architektur an großen Datensätzen trainiert werden, was eine hohe Vorhersagegenauigkeit bietet. Dies ist beispielsweise für Entwickler und Forscher nützlich, die große Textmengen analysieren müssen. Aus diesem Grund Destillieren Sie Bert gilt als leistungsfähiges modernes Modell zur Verarbeitung natürlicher Sprache.

Es bietet eine ausgewogene Lösung für NLP-Aufgaben und liefert hohe Leistung und Genauigkeit bei geringerem Ressourcenverbrauch. Es findet Anwendung in vielen Bereichen, von der Verarbeitung von Kundenfeedback bis hin zur Helpdesk-Automatisierung, und macht fortschrittliche Technologie einem breiten Publikum zugänglich. Unten erfahren Sie, wo das Distillbert-Modell eingesetzt werden kann.

Aufgrund seiner Kompaktheit und Effizienz ist das Modell zu einem wertvollen Werkzeug in zahlreichen Branchen geworden, in denen menschliche Kommunikation und Textvalidierung eine entscheidende Rolle spielen. Seine Fähigkeit, natürliche Sprache zu verarbeiten und zu verstehen, hilft bei der Automatisierung und Lösung verschiedener Aufgaben. Hier sind einige Bereiche, die von diesem Modell betroffen sind:

Einer seiner wichtigsten Anwendungsbereiche ist die Automatisierung des Benutzersupports. Viele Unternehmen integrieren Distilled Bert in ihre Chatbots und Supportsysteme, um Kundenanfragen automatisch zu bearbeiten, schnelle und genaue Antworten zu geben und komplexe Fragen an Live-Betreiber weiterzuleiten. Dies trägt dazu bei, die Arbeitsbelastung der Mitarbeiter zu reduzieren und die Servicequalität zu verbessern.

Ein weiterer wichtiger Anwendungsbereich des Distilbert Huggingface-Modells ist die Analyse des Tons in sozialen Medien und Produktbewertungen. Unternehmen verwenden dieses Modell, um Kundenbewertungen und Erwähnungen in sozialen Medien zu überwachen und zu verstehen, wie Benutzer ihre Produkte oder Dienstleistungen wahrnehmen. Das Modell hilft dabei, Bewertungen automatisch in positiv, negativ und neutral zu kategorisieren, sodass sie auf Kommentare reagieren und ihren Ruf verbessern können.

Das Distilbert-Modell kann große Mengen an Krankenakten verarbeiten und wichtige Informationen über den Patienten kategorisieren, was den Diagnose- und Behandlungsprozess beschleunigt. Es kann beispielsweise verwendet werden, um Symptome automatisch zu kategorisieren, Diagnosen aus Texten zu extrahieren und sogar protokollbasierte Empfehlungen zu generieren.

Huggingface Distilbert wird auch verwendet, um die Textvalidierung zu automatisieren und Schülerantworten zu analysieren. Bildungsplattformen integrieren dieses Modell, um Aufsätze zu bewerten, Plagiate zu erkennen und Sprachkenntnisse zu analysieren. Dies reduziert den Zeitaufwand für die Überprüfung von Aufgaben und ermöglicht eine objektivere Bewertung des Wissens der Schüler. Darüber hinaus können damit intelligente Assistenten erstellt werden, die Schülern bei Hausaufgaben und Prüfungsvorbereitungen helfen.

Distill Bert wird aktiv in Marketing und Werbung eingesetzt. Unternehmen nutzen es, um das Verbraucherverhalten zu analysieren, Zielgruppen zu segmentieren und personalisierte Werbekampagnen zu erstellen. Es hilft bei der Analyse von Textdaten aus Umfragen, Bewertungen und sozialen Medien, sodass Vermarkter die Kundenbedürfnisse und -präferenzen verstehen und ihre Strategien anpassen können, um ihre Zielgruppe anzusprechen.

Distillbert Huggingface kann auch zur Automatisierung von Geschäftsprozessen in einem einfachen Latenode-Workflow verwendet werden. Sie können einen funktionierenden Algorithmus erstellen, der Routineaufgaben anstelle Ihres Teams ausführt, indem Sie Trigger- und Aktionsknoten mit Low-Code-Integrationen verknüpfen. Sehen Sie sich unten an, worum es bei Latenode geht. Sie sehen auch eine Skriptvorlage mit diesem KI-Modell, die Sie kopieren und selbst ausprobieren können.

Latenode ist ein Workflow-Automatisierungstool, mit dem Sie verschiedene Knoten in Ihr Skript integrieren können. Jeder Knoten steht für eine bestimmte Aktion or auslösen. Einfach ausgedrückt: Wenn ein Trigger ausgelöst wird, führt dies unmittelbar zu einer Abfolge von Aktionen – dem Hinzufügen von Informationen zu einer Google-Tabelle, dem Aktualisieren einer Datenbank oder dem Senden einer Nachricht als Reaktion auf eine Benutzeraktion.

Jeder Knoten kann Low-Code-Integrationen enthalten, von KI-Architekturen wie Distilled bert bis hin zu Diensten wie Google Sheets, Chat GPT, Airbox und vielen anderen. Es gibt Hunderte solcher Integrationen in der Latenode-Bibliothek. Wenn Sie den gewünschten Dienst nicht finden können, stellen Sie eine Anfrage an Roadmap oder nutzen Sie die kostenpflichtige Erstveröffentlichung der App Bedienung.

Neben direkten Integrationen können Knoten auch Javascript-Code die entweder Sie oder ein KI-Assistent basierend auf Ihrer Eingabeaufforderung schreiben können. Auf diese Weise können Sie Ihr Skript mit Diensten von Drittanbietern verknüpfen, auch wenn diese nicht in der Sammlung enthalten sind, oder Ihrem Skript benutzerdefinierte Funktionen hinzufügen. Der Assistent kann auch Tools wie Distillbert, Resnet usw. erklären, vorhandenen Code debuggen, Formeln klären oder sogar die Struktur von Skripten vorschlagen, die Sie anpassen können.

Latenode kann außerdem mit verschiedenen API-Systemen kommunizieren, was die Automatisierung weiter vereinfacht. Stellen Sie sich vor, Sie könnten Daten aus Google Maps extrahieren oder sich automatisch mit Daten über Ihre Benutzer anreichern, die sich auf Ihrer Website registrieren. Die Möglichkeiten der automatisierten Skripte sind riesig und der Dienst entwickelt sich ständig weiter.

Wenn Sie Hilfe oder Rat bei der Erstellung Ihres eigenen Skripts benötigen oder dieses Skript replizieren möchten, wenden Sie sich an unsere Discord-Community, wo die Experten für Low-Code-Automatisierung sitzen.

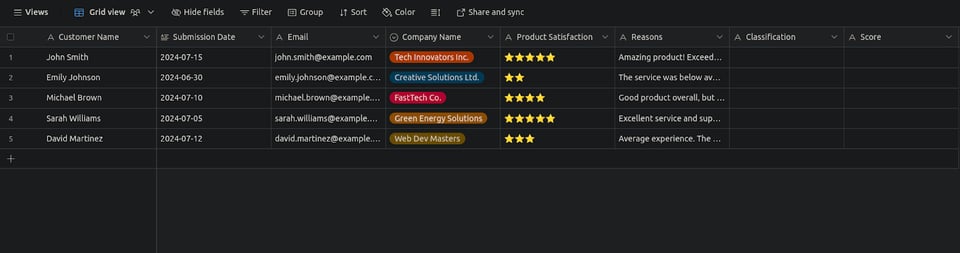

Dieses Skript automatisiert die Verwaltung Ihrer Kundenbewertungen und klassifiziert sie je nach Antwort des Distilbert-Integrationsknotens als positiv oder negativ.

Um dieses Skript zu erstellen, kopieren Sie dies Vorlage in Ihr Latenode-Konto ein, um es bei Bedarf anzupassen. Sie benötigen außerdem einen registrierten Airtable-Konto um eine Tabelle zu erstellen. Das Skript besteht aus sechs Knoten und erfordert keine API-Schlüssel, Codierung oder andere technische Kenntnisse. Hier sind die detaillierten Schritte zur Implementierung jedes Knotens:

.jpeg)

.jpeg)

Wenn Sie den Workflow starten, zieht die erste Airtable-Integration die Liste der Kundenbewertungen und Details aus der Datenbank. Dies kann jede Airtable-Datenbank sein, in der Sie Ihre Informationen speichern, nicht nur die, die diese Vorlage verwendet. Als nächstes gehen die Informationen durch den Iterationsknoten zu Distill bert, das den Text analysiert und eine Wahrscheinlichkeitswert.

Basierend auf diesem Score werden die Daten an einen der beiden folgenden Airtable-Knoten weitergeleitet. Wenn der Score 0.99 beträgt, wird ein Signal an die obere Airtable-Integration gesendet, um sie als positiv in der Tabelle. Wenn das Ergebnis das Gegenteil ist, wird ein ähnliches Signal an den unteren Knoten gesendet, damit dieser es als Negativ. Darüber hinaus veröffentlichen diese Knoten den Punktestand in der Tabelle. So sollte es aussehen:

Dieser Workflow hilft Ihnen, Zeit zu sparen, indem Sie positive oder negative Veröffentlichungen schnell durchlesen. Sie können beispielsweise Bewertungen filtern, um nur die negativen anzuzeigen, um die Autoren zu erreichen und Bereiche zu sehen, in denen der Service verbessert werden kann, oder Sie können Benutzer kontaktieren, die positive Erfahrungsberichte veröffentlicht haben, um ihnen für ihr Interesse und Feedback zu danken.

Die Fähigkeiten des AI Distillbert-Modells sind vielfältig. Mit diesem Modell können Sie Informationen in verschiedene Streams kategorisieren, große Mengen Textdaten analysieren, FAQs automatisieren, Chatbots erstellen, Benutzerinhalte personalisieren, Suchmaschinen mit verbesserten Empfehlungen erweitern usw.

Egal, ob Sie ein erfahrener Entwickler oder ein KI-Neuling sind, die potenziellen Anwendungen von Distilbert können Ihre Projekte verändern. Stellen Sie sich vor, Sie könnten dieses leistungsstarke Tool nutzen, um intelligente Kundensupportlösungen zu entwickeln, Content-Management-Systeme zu optimieren oder anspruchsvolle Datenanalyse-Frameworks zu entwickeln.

Versuchen Sie, mit diesem Modell selbst ein Szenario zu erstellen! Latenode bietet eine kostenlose Version an, mit der Sie bis zu 20 aktive Workflows mit unbegrenzten Knoten einrichten können. Die Aktivierung jedes Workflows verbraucht jedoch 1 Ihrer 300 verfügbaren Credits. Wenn Sie mehr Credits, schnellere Aktivierungszeiten, Zugriff auf AI Code Copilot, unbegrenzte verbundene Konten und zusätzliche Vergünstigungen benötigen, besuchen Sie die Abonnementseite!

Sie können Ihre Entwicklungsmethoden mithilfe der Funktion „Shared Templates“ oder in der Discord-Community von Latenode teilen. Im Zwietracht Gemeinschaftkönnen Sie sich mit anderen Entwicklern vernetzen, Fehler melden, Serviceverbesserungen vorschlagen und neue Erkenntnisse zu Geschäftsautomatisierungstools wie Distilbert oder anderen KI-Modellen gewinnen!

Distilbert ist eine optimierte, effiziente Version des von Hugging Face entwickelten und 2019 eingeführten BERT-Modells für Aufgaben der natürlichen Sprachverarbeitung. Es bietet eine hohe Leistung und verbraucht dabei weniger Rechenressourcen.

Distillbert verwendet einen Prozess namens Destillation, bei dem Wissen aus einem größeren Modell (BERT) auf ein kleineres Modell übertragen wird. Dabei wird das kleinere Modell trainiert, um Daten basierend auf der Ausgabe des größeren Modells vorherzusagen und zu analysieren.

Aufgrund seiner Kompaktheit und Effizienz wird das Distilbert-Modell in der Automatisierung des Kundensupports, der Stimmungsanalyse in sozialen Medien, der Verarbeitung von Krankenakten, auf Bildungsplattformen und in der Marketinganalyse verwendet.

Latenode ist ein Tool zur Workflow-Automatisierung, das die Integration verschiedener Knoten, einschließlich KI-Tools wie dem Distilbert-Modell, ermöglicht, um Geschäftsprozesse mit Low-Code-Konfigurationen zu automatisieren und zu optimieren.

Ein Beispielszenario betrifft die Automatisierung der Klassifizierung von Kundenrezensionen. DistilBERT analysiert den Text, um die Stimmung zu bestimmen, und Latenode leitet die Daten an die entsprechenden Knoten weiter und aktualisiert eine Datenbank mit klassifizierten Rezensionen und Bewertungen.

Distilled Bert bietet eine ähnlich hohe Genauigkeit wie BERT, jedoch mit deutlich reduziertem Rechenleistungsbedarf, was es ideal für ressourcenbeschränkte Umgebungen wie mobile Geräte und Echtzeitanwendungen macht.

Sie können beginnen, indem Sie die Distilbert-Architektur in Workflow-Automatisierungstools wie Latenode integrieren. Dieses bietet eine benutzerfreundliche Oberfläche zum Einrichten KI-gestützter Prozesse, für die nur minimale Programmierkenntnisse erforderlich sind.